cann-AMCT:模型压缩工具深度解读

·

本文基于CANN开源社区的amct仓库进行技术解读

- CANN仓库地址:https://atomgit.com/cann

- 仓库链接:https://atomgit.com/cann/amct

前言

大模型时代,模型参数量动辄上百亿,部署成本高得吓人。如何在保持精度的前提下,把模型"瘦身"?

AMCT(Ascend Model Compression Toolkit,昇腾模型压缩工具)就是解决这个问题的利器。它提供了一整套模型压缩方案,包括量化、剪枝、知识蒸馏等技术,让大模型也能跑在边缘设备上。

什么是AMCT

AMCT是CANN提供的模型压缩工具包,主要功能包括:

- 模型量化(FP16/INT8/INT4)

- 模型剪枝

- 知识蒸馏

- 精度分析

- 自动压缩

简单说,就是把"大胖"模型变成"小瘦"模型,而且不掉精度(或只掉一点点)。

为什么需要模型压缩

1. 推理成本高

# FP32模型

模型大小:70GB × 4字节 = 280GB

显存需求:280GB

推理速度:慢

# INT8量化后

模型大小:70GB × 1字节 = 70GB

显存需求:70GB

推理速度:快4倍

2. 边缘设备限制

手机、摄像头等边缘设备显存有限,无法直接部署大模型。

3. 实时性要求

某些应用场景对延迟要求极高,需要更快的推理速度。

核心功能

1. 模型量化

量化是最常用的压缩技术:

# 量化流程

原始模型(FP32) → 校准数据 → 量化参数(INT8) → 量化模型(INT8)

量化类型

## 量化后训练(QAT)

在训练过程中引入量化,精度损失最小:

quantized_model = amct.quantize_aware_training(

model,

calibration_data=calibration_dataset,

quantization_config={

'weight': 'int8',

'activation': 'int8',

'per_channel': True

}

)

## 量化后训练(PTQ)

训练后直接量化,速度快:

quantized_model = amct.post_training_quantization(

model,

calibration_data=calibration_dataset,

algorithm='kl_divergence' # 或 'min_max', 'entropy'

)

## 动态量化

推理时动态量化,无需校准:

quantized_model = amct.dynamic_quantization(model)

量化策略

## 对称量化

范围:[-127, 127]

公式:q = round(x / scale)

## 非对称量化

范围:[0, 255]

公式:q = round((x - zero_point) / scale)

## 逐通道量化

为每个通道单独计算量化参数,精度更高

## 逐层量化

为每层单独计算量化参数

2. 模型剪枝

剪掉不重要的参数:

# 结构化剪枝

pruned_model = amct.structured_pruning(

model,

pruning_ratio=0.3, # 剪掉30%的通道

pruning_strategy='magnitude' # 或 'grad', 'taylor'

)

# 非结构化剪枝

pruned_model = amct.unstructured_pruning(

model,

sparsity=0.5, # 稀疏度50%

method='l1_unstructured'

)

3. 知识蒸馏

用大模型教小模型:

# 蒸馏训练

teacher_model = load_large_model() # 教师模型

student_model = create_small_model() # 学生模型

distilled_model = amct.knowledge_distillation(

teacher_model=teacher_model,

student_model=student_model,

train_data=train_dataset,

temperature=3.0, # 蒸馏温度

alpha=0.7 # 软标签权重

)

4. 混合压缩

多种技术组合使用:

# 量化 + 剪枝

compressed_model = amct.hybrid_compression(

model,

quantization={'weight': 'int8', 'activation': 'int8'},

pruning={'ratio': 0.2, 'method': 'magnitude'}

)

量化流程

完整量化工作流

精度分析

1. 精度对比

# 精度评估报告

accuracy_report = amct.evaluate_accuracy(

fp32_model,

int8_model,

test_dataset=test_data,

metrics=['top1', 'top5']

)

print(accuracy_report)

# {

# 'fp32_top1': 0.762,

# 'int8_top1': 0.758,

# 'top1_drop': 0.004,

# 'fp32_top5': 0.931,

# 'int8_top5': 0.928,

# 'top5_drop': 0.003

# }

2. 层级精度分析

# 查看每层的精度敏感度

layer_sensitivity = amct.analyze_layer_sensitivity(

model,

calibration_data

)

# 输出各层的量化误差

for layer_name, error in layer_sensitivity.items():

print(f"{layer_name}: {error:.4f}")

3. 可视化分析

# 量化误差分布可视化

amct.visualize_quantization_error(

fp32_model,

int8_model,

output_path='quantization_error.png'

)

# 参数分布对比

amct.visualize_parameter_distribution(

fp32_model,

int8_model,

layer_name='layer1'

)

实战案例

案例:BERT模型INT8量化

import amct

from transformers import BertForSequenceClassification

# 加载原始模型

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

# 准备校准数据

calibration_dataset = load_calibration_data('calibration.txt')

# PTQ量化

quantized_model = amct.post_training_quantization(

model,

calibration_data=calibration_dataset,

quantization_config={

'weight': 'int8',

'activation': 'int8',

'algorithm': 'kl_divergence'

}

)

# 评估精度

accuracy = amct.evaluate_model(

quantized_model,

test_dataset=test_data

)

print(f"INT8精度: {accuracy:.4f}")

print(f"模型大小: {get_model_size(quantized_model):.2f}MB")

案例:Llama 7B量化

# Llama模型量化

model = load_llama_model('llama-7b')

# 使用AWQ算法(Activation-aware Weight Quantization)

quantized_model = amct.awq_quantize(

model,

calibration_data=calibration_dataset,

w_bit=4, # 4-bit量化

a_bit=16, # activation保持16-bit

group_size=128 # 分组量化

)

# 评估量化精度

results = amct.evaluate_quantization(

quantized_model,

test_data=test_data,

metrics=['perplexity', 'accuracy']

)

性能对比

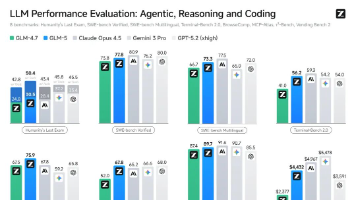

不同量化策略对比

常见问题

Q1:量化后精度下降太多怎么办?

- 尝试QAT(量化感知训练)而非PTQ

- 使用逐通道量化而非逐层量化

- 对敏感层使用更高精度(如混合精度)

- 增加校准数据量

Q2:INT4和INT8怎么选择?

- INT8:精度损失小,推荐首选

- INT4:极致压缩,适合边缘设备,但精度损失较大

Q3:剪枝会影响量化精度吗?

会的。建议先量化再剪枝,或者使用混合压缩工具自动优化。

总结

AMCT是CANN提供的专业模型压缩工具,主要特点:

- 支持多种压缩技术(量化、剪枝、蒸馏)

- 提供PTQ和QAT两种量化方式

- 完整的精度分析工具

- 自动化的压缩流程

对于需要在NPU上部署大模型且资源有限的场景,AMCT是必不可少的工具。

相关链接

- AMCT仓库:https://atomgit.com/cann/amct

- CANN仓库:https://atomgit.com/cann

- AscendCL:https://atomgit.com/cann/ascendcl

昇腾计算产业是基于昇腾系列(HUAWEI Ascend)处理器和基础软件构建的全栈 AI计算基础设施、行业应用及服务,https://devpress.csdn.net/organization/setting/general/146749包括昇腾系列处理器、系列硬件、CANN、AI计算框架、应用使能、开发工具链、管理运维工具、行业应用及服务等全产业链

更多推荐

已为社区贡献28条内容

已为社区贡献28条内容

所有评论(0)