CANN教程:NPU原生NumPy接口asnumpy详解引言

CANN 组织链接: https://atomgit.com/cann

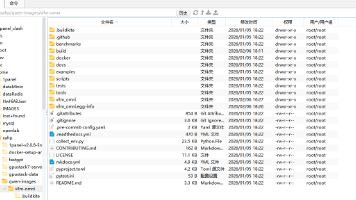

asnumpy仓库链接:https://atomgit.com/cann/asnumpy

目录

(Ascend)NPU作为人工智能计算的重要硬件平台,其CANN(Compute Architecture for Neural Networks)计算架构为开发者提供了强大的AI计算能力。哈尔滨工业大学计算学部苏统华、王甜甜老师团队与CANN团队联合开发的昇腾NPU原生NumPy仓库(Ascend NumPy),将NumPy的易用性与NPU的高性能计算能力相结合,其中asnumpy模块是实现CPU与NPU间数据无缝转换的关键组件。

一、asnumpy概述

1.1 什么是asnumpy

asnumpy是NumPy库中的核心模块,专门用于在NPU张量(Ascend Tensor)与NumPy数组之间进行高效转换。它构建在CANN的AscendCL(Ascend Computing Language)接口之上,实现了计算设备间的数据桥梁功能。

1.2 与传统NumPy的差异

与传统NumPy纯CPU计算不同,asnumpy操作的对象是存储在NPU设备内存中的张量数据。这种设计使得数据无需在CPU和NPU间频繁复制,即可利用NPU的并行计算能力。

二、环境安装与配置

2.1 安装准备

bash

# 安装CANN基础环境(需提前部署) # 安装Ascend NumPy pip install ascend-numpy

2.2 环境验证

python

import ascend.numpy as anp

print(f"Ascend NumPy版本: {anp.__version__}")

print(f"asnumpy模块可用性: {'asnumpy' in dir(anp)}")

三、核心功能详解

3.1 基础转换操作

3.1.1 NumPy数组转Ascend Tensor

python

import numpy as np

import ascend.numpy as anp

# 创建普通NumPy数组

cpu_array = np.random.randn(3, 4).astype(np.float32)

print("CPU数组类型:", type(cpu_array))

# 转换为Ascend Tensor(自动上传至NPU)

np_tensor = anp.asarray(cpu_array)

print("NPU张量类型:", type(np_tensor))

print("存储设备:", np_tensor.device)

3.1.2 Ascend Tensor转NumPy数组

python

# 在NPU上执行计算

np_tensor_squared = np_tensor ** 2

# 转换回NumPy数组(自动下载到CPU)

cpu_result = anp.asnumpy(np_tensor_squared)

print("转换后类型:", type(cpu_result))

print("数据一致性验证:", np.allclose(cpu_result, cpu_array**2))

3.2 内存管理与优化

3.2.1 内存池配置

python

# 启用内存池优化(减少内存分配开销) anp.enable_memory_pool() # 配置内存池大小 anp.set_memory_pool_size(device="npu", size=1024*1024*1024) # 1GB

3.2.2 显式内存管理

python

# 手动控制数据传输 tensor_on_npu = anp.asarray(cpu_array, copy=False) # 零拷贝上传 # 异步数据传输 tensor_async = anp.asarray(cpu_array, stream="async") result = anp.asnumpy(tensor_async, wait=False) # 非阻塞下载 result.wait() # 显式等待完成

3.3 高级特性

3.3.1 流式处理

python

# 创建计算流

stream = anp.Stream()

# 在指定流中进行转换

with stream:

tensor = anp.asarray(cpu_array)

# 执行NPU计算

result = anp.matmul(tensor, tensor.T)

cpu_result = anp.asnumpy(result)

stream.synchronize() # 等待流中所有操作完成

3.3.2 跨设备转换

python

# 多NPU设备支持

tensor_device0 = anp.asarray(cpu_array, device="npu:0")

# 设备间数据传输

tensor_device1 = tensor_device0.to("npu:1")

# 转回CPU

cpu_data = anp.asnumpy(tensor_device1)

四、性能最佳实践

4.1 批量数据传输优化

python

def batch_process(data_list):

"""批量处理优化示例"""

# 批量上传至NPU

npu_tensors = [anp.asarray(data) for data in data_list]

# 在NPU上批量计算

results = [tensor * 2 + 1 for tensor in npu_tensors]

# 批量下载结果

return [anp.asnumpy(result) for result in results]

4.2 内存复用策略

python

# 预分配缓冲区

buffer_npu = anp.empty((1024, 1024), dtype=anp.float32)

buffer_cpu = np.empty((1024, 1024), dtype=np.float32)

# 复用缓冲区进行数据传输

def efficient_transfer(data):

buffer_cpu[:] = data # 复用CPU缓冲区

buffer_npu = anp.asarray(buffer_cpu) # 复用NPU缓冲区

return buffer_npu

4.3 异步处理流水线

python

import threading

import queue

class AsyncProcessor:

def __init__(self, batch_size=4):

self.stream = anp.Stream()

self.queue = queue.Queue()

def upload_async(self, data):

"""异步上传数据"""

with self.stream:

return anp.asarray(data)

def download_async(self, tensor):

"""异步下载结果"""

with self.stream:

return anp.asnumpy(tensor, wait=False)

五、常见问题与调试

5.1 数据类型兼容性

python

# 支持的数据类型检查

supported_dtypes = [anp.float16, anp.float32, anp.int32]

cpu_array = np.array([1, 2, 3], dtype=np.int64)

try:

tensor = anp.asarray(cpu_array) # 可能引发类型转换

except TypeError as e:

# 自动类型转换

tensor = anp.asarray(cpu_array.astype(np.int32))

5.2 内存不足处理

python

def safe_transfer_large_array(array):

"""大数组安全传输"""

try:

return anp.asarray(array)

except anp.MemoryError:

# 分块传输策略

chunks = np.array_split(array, 4)

tensor_chunks = [anp.asarray(chunk) for chunk in chunks]

return anp.concatenate(tensor_chunks)

5.3 性能监控

python

import time

def benchmark_transfer(array):

"""数据传输性能测试"""

start = time.time()

# 预热

tensor = anp.asarray(array)

_ = anp.asnumpy(tensor)

# 实际测试

start_time = time.perf_counter()

tensor = anp.asarray(array)

upload_time = time.perf_counter() - start_time

start_time = time.perf_counter()

cpu_data = anp.asnumpy(tensor)

download_time = time.perf_counter() - start_time

print(f"上传时间: {upload_time:.4f}s")

print(f"下载时间: {download_time:.4f}s")

return upload_time + download_time

六、实际应用示例

6.1 深度学习推理流程

python

class NPUInferencePipeline:

def __init__(self, model_path):

self.model = load_npu_model(model_path)

def inference(self, input_data):

# 输入数据转换

input_tensor = anp.asarray(input_data)

# NPU推理

with anp.Stream() as stream:

output_tensor = self.model(input_tensor)

# 异步获取结果

output_future = anp.asnumpy(output_tensor, wait=False)

# 等待并返回结果

return output_future.wait()

6.2 科学计算加速

python

def npu_accelerated_computation(data):

"""利用NPU加速的科学计算"""

# 大规模矩阵运算

tensor_a = anp.asarray(data['matrix_a'])

tensor_b = anp.asarray(data['matrix_b'])

# 在NPU上执行复杂计算

result = anp.linalg.svd(

anp.matmul(tensor_a, tensor_b) + anp.eye(tensor_a.shape[0])

)

# 选择性下载结果

u = anp.asnumpy(result[0]) # 只下载需要的部分

return u

七、总结

asnumpy作为NPU原生NumPy生态的关键组件,极大地简化了CPU与NPU间的数据交互。通过本教程,我们了解到:

-

易用性:保持NumPy API风格,降低学习成本

-

高性能:支持异步传输、内存池优化等高级特性

-

灵活性:提供细粒度的内存和流控制

-

实用性:可直接应用于深度学习推理、科学计算等场景

随着AI生态的不断完善,asnumpy将继续优化其性能表现,为开发者提供更高效的异构计算体验。建议在实际使用中结合具体应用场景,合理选择同步/异步传输策略,充分利用NPU的计算能力。

昇腾计算产业是基于昇腾系列(HUAWEI Ascend)处理器和基础软件构建的全栈 AI计算基础设施、行业应用及服务,https://devpress.csdn.net/organization/setting/general/146749包括昇腾系列处理器、系列硬件、CANN、AI计算框架、应用使能、开发工具链、管理运维工具、行业应用及服务等全产业链

更多推荐

已为社区贡献22条内容

已为社区贡献22条内容

所有评论(0)