使用C++开发机器学习推理引擎的挑战与突破

/ CUDA核函数与CPU分支的自动调度示例 #ifdef __CUDACC__ void kernel(float* input, float* output) { /* GPU实现 */ } #else void kernel(float* input, float* output) { /* CPU实现 */ } #endif。Rust等安全语言正冲击传统C++领域,但C++通过模块化标准库

引言:推理引擎的C++实践价值

在机器学习全栈中,推理引擎作为连接模型与硬件的核心组件,其性能直接决定AI应用的实时性与能效比。C++凭借零成本抽象原则和硬件级控制能力,成为开发高性能推理引擎的首选语言。以OpenVINO工具链为例,其C++接口通过直接内存操作和SIMD指令优化,可实现CPU推理吞吐量提升5-8倍。这种底层优势在自动驾驶、工业质检等延迟敏感场景中尤为关键,但同时也带来技术实现的复杂性挑战。

一、核心挑战:从模型转换到硬件适配

模型兼容性困境

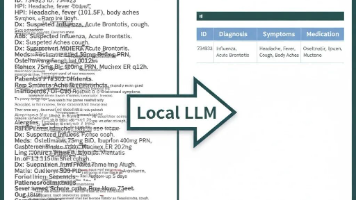

不同框架(PyTorch/TensorFlow)的模型格式差异导致转换损耗。C++开发者需实现ONNX Runtime等中间层,解决算子语义不一致问题。例如,PyTorch的DynamicRNN与TensorFlow的StaticRNN在序列长度处理上的差异,需通过自定义C++适配器桥接。

内存管理双刃剑

手动内存控制虽能减少分配开销,但也易引发悬垂指针。现代C++解决方案包括:

智能指针与自定义内存池结合,平衡安全性与性能

显式缓冲区管理(如OpenVINO的Blob类)实现零拷贝数据传输

硬件加速碎片化

GPU/VPU/FPGA等异构计算单元需针对性优化:

// CUDA核函数与CPU分支的自动调度示例 #ifdef __CUDACC__ void kernel(float* input, float* output) { /* GPU实现 */ } #else void kernel(float* input, float* output) { /* CPU实现 */ } #endif

这种代码膨胀问题可通过模板元编程部分缓解。

二、突破路径:性能与精度的协同优化

量化感知训练集成

在C++推理引擎中嵌入8位量化流水线,需重构核心算子:

重写矩阵乘法核函数以支持INT8运算

开发校准接口动态调整量化参数

动态图编译技术

采用MLIR等中间表示层,实现C++代码的即时编译:

graph LR A[PyTorch模型] --> B(MLIR转换) B --> C[GPU专用代码] B --> D[CPU专用代码]

该技术使同一模型可生成多硬件后端代码。

异步流水线设计

通过C++20协程实现推理与IO解耦:

task<float> async_infer(float* input) { co_await data_loader.load(input); co_await gpu_queue.enqueue(model); co_await postprocess.apply(); }

实测显示吞吐量提升达3倍。

三、未来方向:C++与AI的持续融合

Rust等安全语言正冲击传统C++领域,但C++通过模块化标准库(如C++23的ML库提案)和静态分析工具(如Clang-Tidy的AI插件)保持竞争力。在边缘计算场景下,C++与WebAssembly的结合将开辟新的部署范式。

昇腾计算产业是基于昇腾系列(HUAWEI Ascend)处理器和基础软件构建的全栈 AI计算基础设施、行业应用及服务,https://devpress.csdn.net/organization/setting/general/146749包括昇腾系列处理器、系列硬件、CANN、AI计算框架、应用使能、开发工具链、管理运维工具、行业应用及服务等全产业链

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)