Qwen2.5-Omni 7B 模型部署:镜像下载、环境安装及 demo 启动指南

本文详细阐述了 Qwen2.5-Omni-7B 模型的部署及演示运行过程。首先介绍了使用 modelscope 下载 Qwen/Qwen2.5-Omni-7B 模型至指定目录,以及拉取 qwenllm/qwen-omni:2.5-cu121 的 docker 镜像。接着说明了安装 NVIDIA Docker 工具包(nvidia-docker2)并重启 docker 的操作,以确保能在 Docke

·

本文采用docker方式启动

参考:https://github.com/QwenLM/Qwen2.5-Omni

下载模型

modelscope download --model Qwen/Qwen2.5-Omni-7B --local_dir /usr/local/ai/models/Qwen2.5-Omni-7B下载docker镜像(耗时较长,耐心等待)

docker pull qwenllm/qwen-omni:2.5-cu121下载后看一看模型有多大(约22G)

(base) root@deepseek:~# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

qwenllm/qwen-omni 2.5-cu121 04b7452fcedc 26 hours ago 22.1GB

安装 NVIDIA Docker 工具包(nvidia-docker2) ,它允许在 Docker 容器中使用 NVIDIA GPU

sudo apt-get install -y nvidia-docker2重启docker

sudo systemctl restart docker下载开源项目

cd /usr/local/ai/git-codes

git clone https://github.com/QwenLM/Qwen2.5-Omni.git

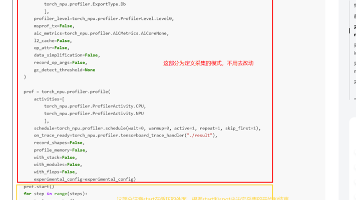

cd /usr/local/ai/git-codes/Qwen2.5-Omni/docker修改 docker_web_demo.sh,注释掉docker pull部分,因为前面已经拉取了

- 修改前备份

cp docker_web_demo.sh docker_web_demo.bak.sh- 修改docker_web_demo.sh内容:

运行demo

#进入目录

cd /usr/local/ai/git-codes/Qwen2.5-Omni

#运行demo(/usr/local/ai/models/Qwen2.5-Omni-7B是modelscope下载模型后存放位置)

bash docker/docker_web_demo.sh --checkpoint /usr/local/ai/models/Qwen2.5-Omni-7B

#输出:

41e9574eae11d646cb1b7d64ad14273e041d5fa344ef1b1f07700416639d170b

Successfully started web demo. Open 'http://localhost:8901' to try!

Run `docker logs qwen2.5-omni` to check demo status.

Run `docker rm -f qwen2.5-omni` to stop and remove the demo.浏览器访问(默认8091端口)

说明:若gpu不足,但是需要执行较大图片、视频的对话,会出现错误。

用docker logs qwen2.5-omni命令可以看到如下类似的错误信息:

torch.OutOfMemoryError: CUDA out of memory. Tried to allocate 53.56 GiB.

昇腾计算产业是基于昇腾系列(HUAWEI Ascend)处理器和基础软件构建的全栈 AI计算基础设施、行业应用及服务,https://devpress.csdn.net/organization/setting/general/146749包括昇腾系列处理器、系列硬件、CANN、AI计算框架、应用使能、开发工具链、管理运维工具、行业应用及服务等全产业链

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)